A Boston Dynamics publicou um novo vídeo destacando como seu novo Atlas Humanoid eletrônico executa tarefas no laboratório. Você pode assistir ao vídeo acima.

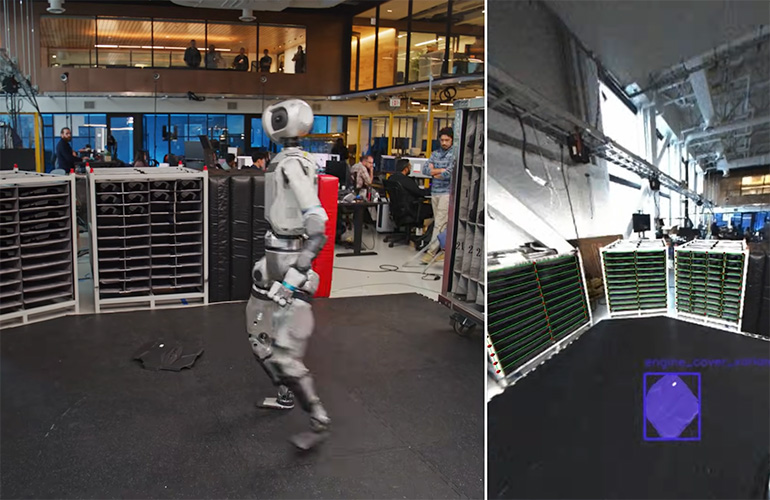

A primeira coisa que me atinge do vídeo é como o Atlas mostra sua percepção em tempo real. O vídeo mostra como o Atlas registra ativamente seu quadro de referência para as capas do motor e todos os locais de colheita/local. O robô atualiza continuamente sua compreensão do mundo para lidar com as peças de maneira eficaz. Quando pega algo, avalia a topologia da peça – como lidar com isso e onde colocá -la.

Atlas percebe a topologia da parte mantida em suas mãos, pois adquire a parte da prateleira. | Crédito: Boston Dynamics

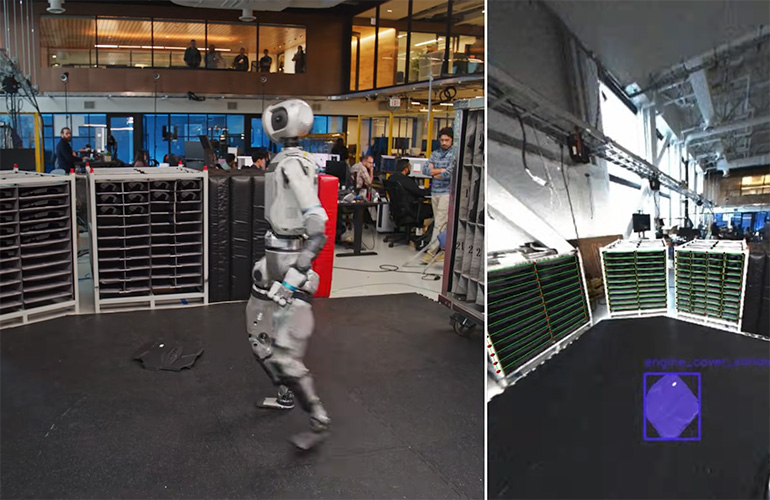

Então, há um momento às 1:14 na demonstração em que um engenheiro deixou cair uma tampa do motor no chão. Atlas parecia ouvir a capa atingir o chão. O humanóide então olha em volta, localiza a peça, descobre como buscá -lo (novamente, avaliar sua forma) e o coloca com a precisão necessária na área de cobertura do motor.

O relatório do robô Entrou em contato com a Boston Dynamics para saber mais sobre como Atlas sabia que uma parte era jogada no chão. Atualizaremos este artigo se recebermos resposta.

“Quando o objeto está em vista das câmeras, o Atlas usa um modelo de estimativa de pose de objeto que usa uma abordagem de renderização e compras para estimar pose de imagens monoculares”, Boston Dynamics escreveu em um blog sobre o vídeo. “O modelo é treinado com dados sintéticos em larga escala e generaliza zero para novos objetos, dado um modelo CAD. Quando inicializado com uma pose 3D anterior, o modelo o refina iterativamente para minimizar a discrepância entre o modelo CAD renderizado e a imagem da câmera capturada. As hipóteses que são alimentadas a um modelo de pontuação, e a hipótese de melhor ajuste é posteriormente refinada.

O vídeo destaca a capacidade da Atlas de adaptar e perceber seu ambiente, ajustar seu conceito desse mundo e ainda seguir sua tarefa atribuída. Ele mostra como o Atlas pode lidar com ambientes caóticos, manter sua tarefa objetiva e fazer alterações em sua missão em tempo real.

O Atlas pode escanear o chão e identificar uma parte no chão que não pertence a lá. | Crédito: Boston Dynamics

Entendo, portanto eu sou

A orientação da Visão de Robôs tem sido viável desde os anos 90. Naquela época, os robôs podem rastrear itens em transportadores em movimento e ajustar os quadros locais de referência para uma montagem da placa de circuito com base em fiduciais. Nada é surpreendente ou novo sobre esse estado da arte para a orientação da visão de robôs.

O que é único agora para os humanóides é a mobilidade do robô. Qualquer manipulador móvel deve atualizar consistentemente seu mapa mundial. A orientação moderna da visão de robôs usa modelos de linguagem de visão (VLM) para entender o mundo através dos olhos da câmera.

Esses robôs industriais mais antigos foram fixados no solo e usaram uma visão 2D e rotinas de calibração complexas para mapear o campo de visão da câmera. O que estamos vendo demonstrado com o Atlas é um robô móvel e humanóide que entende seu ambiente e continua sua tarefa, mesmo quando o ambiente muda em torno do robô. Os robôs modernos têm um entendimento 3D do mundo ao seu redor.

O Boston Dynamics admite que essa demonstração é uma mistura de funções baseadas em IA (como a percepção) e alguma programação processual para gerenciar a missão. O vídeo é uma boa demonstração da progressão dos recursos da evolução do software. Para que esses sistemas funcionem no mundo real, eles devem lidar com mudanças sutis e alterações macro em seus ambientes operacionais.

Fazendo o seu caminho através do mundo

É fascinante assistir Atlas se mover. Os movimentos, às vezes, parecem um pouco estranhos, mas é uma excelente ilustração de como a IA percebe o mundo e as escolhas que faz para se mover pelo mundo. Só conseguimos testemunhar uma pequena fatia dessa tomada de decisão no vídeo.

O Boston Dynamics publicou anteriormente um vídeo mostrando comportamentos baseados em MOCAP (MOCAP). O vídeo MOCAP demonstra a agilidade do sistema e o que ele pode fazer com a entrada suave. O empurrão deste vídeo mais recente, sob a tomada de decisão e controle da IA, está muito longe das demonstrações MOCAP que envolvem o Vale Excanny. Também apresentamos o Boston Dynamics CTO Aaron Saunders como apresentador de palestras no 2025 Robotics Summit and Expo em Boston.

Ainda existe muito processamento em tempo real para a Atlas compreender seu mundo. No vídeo, vemos o robô parando para processar o meio ambiente, antes de tomar uma decisão e continuar. Estou confiante de que isso só ficará mais rápido com o tempo, à medida que o código evolui e os modelos de IA se tornam melhores em sua compreensão e adaptabilidade. Eu acho que é aí que está a corrida agora: desenvolver o software baseado em IA que permite que esses robôs se adaptem, entendam seu ambiente e aprendam continuamente com uma variedade de dados multimodais.