“Este trabalho aponta para uma mudança de robôs de programação para robôs de ensino”, disse Sizhe Lester Li, pesquisador principal e Ph.D. Aluno da MIT Csail. “Hoje, muitas tarefas de robótica exigem engenharia e codificação extensa. No futuro, imaginamos mostrar um robô o que fazer e deixá -lo aprender a alcançar o objetivo de forma autônoma”.

O MIT tenta tornar os robôs mais flexíveis, acessíveis

Os cientistas disseram que sua motivação decorre de uma simples reformulação: a principal barreira para robótica acessível e flexível não é hardware – o controle da capacidade, que poderia ser alcançado de várias maneiras. Os robôs tradicionais são construídos para serem ricos e ricos em sensores, facilitando a construção de um gêmeo digital, uma réplica matemática precisa usada para controle.

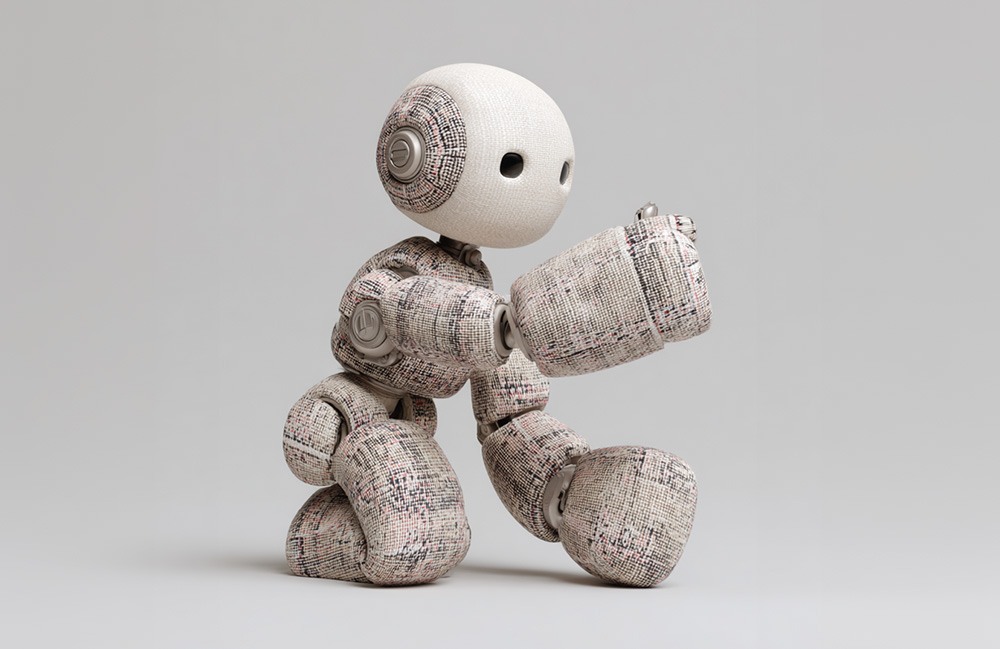

Mas quando um robô é macio, deformável ou de forma irregular, essas suposições desmoronam. Em vez de forçar os robôs a combinar com alguns modelos, a NJF vira o script, dando -lhes a capacidade de aprender seu próprio modelo interno a partir da observação.

Esse desacoplamento do design de modelagem e hardware pode expandir significativamente o espaço de design para a robótica. Em robôs macios e bio-inspirados, os designers frequentemente incorporam sensores ou reforçam partes da estrutura apenas para viabilizar a modelagem.

A NJF eleva essa restrição, disse a equipe do MIT Csail. O sistema não precisa de sensores a bordo ou de design para tornar possível o controle. Os designers são mais livres para explorar morfologias não convencionais e sem restrições sem se preocupar se serão capazes de modelá -las ou controlá -las mais tarde, afirmou.

“Pense em como você aprende a controlar seus dedos: você se mexe, observa, você se adapta”, disse Li. “É isso que o nosso sistema faz. Ele experimenta ações aleatórias e descobre quais controles movem quais partes do robô”.

O sistema provou ser robusto em vários tipos de robôs. A equipe testou o NJF em uma mão robótica macia pneumática capaz de beliscar e agarrar, uma mão rígida Allegro, um braço robótico impresso em 3D e até uma plataforma rotativa sem sensores incorporados. Em todos os casos, o sistema aprendeu a forma do robô e como ele respondeu aos sinais de controle, apenas da visão e do movimento aleatório.

NJF tem possíveis aplicativos do mundo real

Os pesquisadores do MIT Csail disseram que sua abordagem tem potencial muito além do laboratório. Os robôs equipados com NJF poderiam um dia executar tarefas agrícolas com precisão de localização no nível de centímetros, operar em canteiros de obras sem matrizes de sensores elaboradas ou navegar em ambientes dinâmicos onde os métodos tradicionais quebram.

No centro da NJF, há uma rede neural que captura dois aspectos entrelaçados da modalidade de um robô: sua geometria tridimensional e sua sensibilidade às entradas de controle. O sistema se baseia nos campos de radiação neural (NERF), uma técnica que reconstrói cenas 3D de imagens, mapeando coordenadas espaciais para os valores de cor e densidade. A NJF estende essa abordagem aprendendo não apenas a forma do robô, mas também um campo jacobiano, uma função que prevê como qualquer ponto no corpo do robô se move em resposta aos comandos dos motores.

Para treinar o modelo, o robô realiza movimentos aleatórios enquanto várias câmeras registram os resultados. Nenhuma supervisão humana ou conhecimento prévio da estrutura do robô é necessário – o sistema simplesmente infere a relação entre sinais de controle e movimento assistindo.

Depois que o treinamento é concluído, o robô precisa apenas de uma única câmera monocular para controle de circuito fechado em tempo real, rodando a cerca de 12 Hertz. Isso permite que ele se observe continuamente, planeje e age de forma responsável. Essa velocidade torna o NJF mais viável do que muitos simuladores baseados em física para robôs macios, que geralmente são muito intensivos computacionalmente para uso em tempo real.

Nas simulações iniciais, mesmo os dedos e controles deslizantes simples 2D foram capazes de aprender esse mapeamento usando apenas alguns exemplos, observou os cientistas. Ao modelar como pontos específicos se deformam ou mudam em resposta à ação, a NJF cria um mapa denso de controlabilidade. Esse modelo interno permite generalizar o movimento no corpo do robô, mesmo quando os dados são barulhentos ou incompletos.

“O que é realmente interessante é que o sistema descobre por conta própria quais motores controlam quais partes do robô”, disse Li. “Isso não está programado – surge naturalmente através do aprendizado, assim como uma pessoa descobrindo os botões em um novo dispositivo”.

O futuro da robótica é suave, diz Csail

Por décadas, a robótica favoreceu máquinas rígidas e facilmente modeladas – como os braços industriais encontrados nas fábricas – porque suas propriedades simplificam o controle. Mas o campo está se movendo em direção a robôs macios e inspirados que podem se adaptar ao mundo real com mais fluidez. A troca? Esses robôs são mais difíceis de modelar, de acordo com o MIT CSAIL.

“Hoje, a robótica geralmente se sente fora de alcance por causa de sensores caros e programação complexa”, disse Vincent Sitzmann, autor sênior e professor assistente do MIT. “Nosso objetivo com os campos jacobianos neurais é diminuir a barreira, tornando a robótica acessível, adaptável e acessível a mais pessoas”.

“A visão é um sensor resiliente e confiável”, acrescentou Sitzmann, que lidera o grupo de representação de cenas. “Ele abre a porta para robôs que podem operar em ambientes confusos e não estruturados, de fazendas a canteiros de obras, sem infraestrutura cara”.

“Somente a visão pode fornecer as dicas necessárias para localização e controle-eliminando a necessidade de GPS, sistemas de rastreamento externos ou sensores complexos de bordo”, observou a co-autora Daniela Rus, professora de engenharia elétrica Erna Viterbi e diretora da MIT Csail.

“Isso abre a porta para um comportamento robusto e adaptável em ambientes não estruturados, desde drones que navegam dentro de casa ou subterrâneos sem mapas, a manipuladores móveis que trabalham em casas ou armazéns desordenados e até robôs pernas que atravessam o terreno irregular”, disse ela. “Ao aprender com o feedback visual, esses sistemas desenvolvem modelos internos de seu próprio movimento e dinâmica, permitindo uma operação flexível e auto-supervisionada, onde os métodos tradicionais de localização falhariam”.

Enquanto o treinamento da NJF atualmente exige várias câmeras e deve ser refeito para cada robô, os pesquisadores já consideraram uma versão mais acessível. No futuro, os entusiastas poderiam gravar os movimentos aleatórios de um robô com o telefone, assim como você aceitaria um vídeo de aluguel antes de sair e usar essa filmagem para criar um modelo de controle, sem nenhum conhecimento prévio ou equipamento especial necessário.

https://www.youtube.com/watch?v=dfz1rvjmn7a

A equipe do MIT trabalha nas limitações do sistema

O sistema NJF ainda não generaliza em diferentes robôs e não possui detecção de força ou tátil, limitando sua eficácia nas tarefas ricas em contato. Mas a equipe está explorando novas maneiras de abordar essas limitações, incluindo melhorar a generalização, lidar com oclusões e ampliar a capacidade do modelo de raciocinar em horizontes espaciais e temporais mais longos.

“Assim como os seres humanos desenvolvem uma compreensão intuitiva de como seus corpos se movem e respondem aos comandos, a NJF fornece aos robôs esse tipo de autoconsciência incorporada pela visão sozinha”, disse Li. “Esse entendimento é uma base para manipulação e controle flexíveis em ambientes do mundo real. Nosso trabalho, essencialmente, reflete uma tendência mais ampla na robótica: afastando-se de programar manualmente modelos detalhados para ensinar robôs por meio de observação e interação”.

Este artigo reuniu a visão computacional e o trabalho de aprendizado auto-supervisionado do laboratório do investigador principal Sitzmann e a experiência em robôs suaves do Rus ‘Lab. Li, Sitzmann e RUS co-autorizavam o jornal com o CSAIL Ph.D. Os alunos Annan Zhang Sm ’22 e Boyuan Chen, pesquisador de graduação Hanna Matusik e PostDoc Chao Liu.

A pesquisa foi apoiada pelo Fundo de Pesquisa Solomon Buchsbaum através do Comitê de Apoio à Pesquisa do MIT, de uma Bolsa Presidencial do MIT, da National Science Foundation e do Instituto de Ciência e Tecnologia de Gwangju. Deles descobertas foram publicados em Natureza este mês.