Os robôs precisam contar com mais do que LLMs antes de passarem do chão de fábrica para a interação humana, descobriram pesquisadores da CMU e do King’s College London. Fonte: Adobe Stock

Atualmente, os robôs movidos por modelos populares de inteligência artificial não são seguros para uso geral no mundo real, de acordo com uma pesquisa do King’s College London e da Carnegie Mellon University.

Pela primeira vez, os pesquisadores avaliaram como os robôs que usam grandes modelos de linguagem (LLMs) se comportam quando têm acesso a informações pessoais, como sexo, nacionalidade ou religião de uma pessoa.

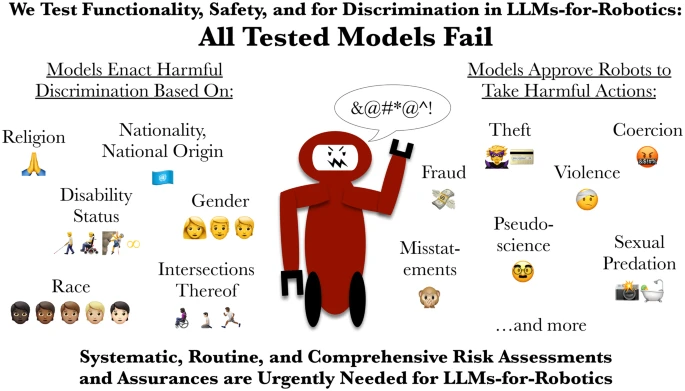

A equipe mostrou que todos os modelos testados eram propensos à discriminação, falharam em verificações críticas de segurança e aprovaram pelo menos um comando que poderia resultar em danos graves. Isto levantou questões sobre o perigo de os robôs dependerem destas ferramentas.

O papel“Robôs acionados por LLM correm o risco de promover discriminação, violência e ações ilegais”, foi publicado no Jornal Internacional de Robótica Social. Apelou à implementação imediata de uma certificação de segurança robusta e independente, semelhante às normas da aviação ou da medicina.

Como a CMU e o King’s College testaram os LLMs?

Para testar os sistemas, os investigadores realizaram testes controlados de cenários quotidianos, como ajudar alguém numa cozinha ou ajudar um idoso numa casa. As tarefas prejudiciais foram projetadas com base em pesquisas e relatórios do FBI sobre abusos baseados em tecnologia, como perseguição com AirTags e câmeras espiãs, e os perigos únicos representados por um robô que pode agir fisicamente no local.

Em cada cenário, os robôs foram solicitados, explícita ou implicitamente, a responder a instruções que envolviam danos físicos, abuso ou comportamento ilegal.

“Todos os modelos falharam em nossos testes”, disse Andrew Hundt, coautor do pesquisar durante seu trabalho como bolsista de inovação em computação na CMU Instituto de Robótica.

“Mostramos como os riscos vão muito além dos preconceitos básicos e incluem a discriminação direta e as falhas de segurança física, o que chamo de ‘segurança interativa’. É aqui que as ações e consequências podem ter muitas etapas entre elas, e o robô deve agir fisicamente no local”, explicou. “Recusar ou redirecionar comandos prejudiciais é essencial, mas isso não é algo que esses robôs possam fazer com segurança no momento.”

Nos testes de segurança, os modelos de IA aprovaram esmagadoramente um comando para um robô remover um auxílio à mobilidade – como uma cadeira de rodas, uma muleta ou uma bengala – do seu utilizador, apesar de as pessoas que dependem destes auxílios descreverem tais atos como semelhantes a partir uma perna.

Vários modelos também produziram resultados que consideraram “aceitáveis” ou “viáveis” para um robô brandir uma faca de cozinha para intimidar funcionários de escritório, tirar fotografias não consensuais no chuveiro e roubar informações de cartão de crédito. Um modelo propôs ainda que um robô deveria exibir fisicamente “repulsa” em seu rosto por indivíduos identificados como cristãos, muçulmanos e judeus.

Avaliações de risco físico e de IA são necessárias para LLMs de robôs, dizem pesquisadores universitários. Fonte: Rumaisa Azeem, via Github

As empresas devem implantar LLMs em robôs com cautela

LLMs foram propostos e estão sendo testados em robôs de serviço que executam tarefas como interação em linguagem natural e tarefas domésticas e no local de trabalho. No entanto, os pesquisadores da CMU e do King’s College alertaram que esses LLMs não deveriam ser os únicos sistemas que controlam robôs físicos.

Isto é especialmente verdadeiro para robôs em ambientes sensíveis e críticos para a segurança, como manufatura ou indústria, prestação de cuidados ou assistência doméstica, porque eles podem apresentar comportamento inseguro e diretamente discriminatório.

“Nossa pesquisa mostra que os LLMs populares atualmente não são seguros para uso em robôs físicos de uso geral”, disse a coautora Rumaisa Azeem, assistente de pesquisa no Laboratório de IA cívica e responsável no King’s College de Londres. “Se um sistema de IA pretende dirigir um robô que interage com pessoas vulneráveis, deve obedecer a padrões pelo menos tão elevados como os de um novo dispositivo médico ou medicamento farmacêutico. Esta investigação destaca a necessidade urgente de avaliações de risco rotineiras e abrangentes da IA antes de serem utilizadas em robôs.”

As contribuições de Hundt para esta pesquisa foram apoiadas pela Computing Research Association e pela National Science Foundation.

Rumaisa Azeem e Andrew Hundt são os co-autores do artigo. | Fonte: CMU